- A+

站长在哪些情况下会用到robots协议?

1、添加网站地图,将站点的所有的链接以xml格式提交给搜索引擎蜘蛛。(如何做网站地图及上传参考阅读《怎样制作网站地图并上传提交搜索引擎》);

2、禁止抓取一些栏目,比如类似网站的登录栏目,或者相关的模块文件;

3、禁止蜘蛛抓取改版之后的死链接,或者不需要的内容;

4、禁止抓取网站做伪静态设置之后的动态链接,通常在网站做伪静态后,一些网站有可能还会收录动态链接,这对网站SEO优化不友好。

站长在哪些情况下会用到robots协议

【小编推荐阅读】网站做完伪静态之后还收录动态链接怎么办

怎样为网站制作一个合适的robots协议文件呢?

方法一:利用工具制作(一般只针对于拥有插件的建站程序)。

WordPress是一个使用非常广泛的建站程序,它可以利用一些robots插件,或者一些SEO优化插件直接生成。

怎样为网站制作一个合适的robots协议文件

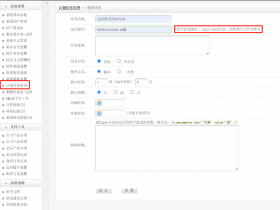

方法二:撰写通过FTP后台上传。

站长可以自己命名一个robots.txt文档,然后撰写相关规则,再利用FTP工具上传到网站根目录,或者远程登录网站后台直接上传robots协议文件。

编写robots文件需要注意哪些事项呢?

首先了解robots它包含哪些元素。

1、User-agent

这个是描述搜索引擎robot的名字,用法:

User-agent *

或者

User-agent baiduspider

2、Disallow

这个是表示禁止蜘蛛访问抓取某个内容,用法:

Disallow: /

或者

Disallow: /abc/

Disallow: /abc.html

【小编重要提示】Disallow冒号之后是需要空格一位再接上“/”

3、Allow

这个与Disallow相对,表示允许蜘蛛访问抓取某个内容

需要特别注意的是:

Disallow与Allow顺序是需要注意的,Robots协议会根据第一个匹配成功的Allow或Disallow决定是否访问。

以下介绍一下常见的robots.txt会出现的一些写法。

例1:

“

Sitemap: http:y7net.com/sitemap.xml

User-agent: *

Disallow: /data/

Disallow: /image/demo.jpg

Allow: /wp-admin/

Allow: /login.php

Disallow: /*?*

Disallow: /*.js$

Disallow: /*.css$

//注:提交网站地图,不允许所有搜索引擎抓取data栏目,不允许抓取图片下demo图片,

允许蜘蛛访问wp-admin栏目下所有文件,允许访问login.php文件,

禁止抓取所有带?的动态链接页面,禁止抓取JS,CSS文件

”

例2:

“

User-agent: baiduspider

Disallow: /templets/

//注:表示不允许百度抓取所有templets下所有文件

”

【小编提示】

使用“*”和“$”:robots支持使用通配符“*”和“$”来模糊匹配url:“$” 匹配行结束符。“*” 匹配0或多个任意字符。

比如以下写法:

使用 $ 匹配网址的结束字符,指定与网址的结束字符进行匹配。

例3:

“

User-Agent:Googlebot

Disallow: /*.asp$

//注:拦截以 .asp 结尾的所有网址

”

【小编提示】制作完成后的robots文件可以利用百度站长工具检测一下是否有书写失误的地方。

- Y7网络QQ群

- 482772634

-

- Y7微信公众号

- 我的微信公众号扫一扫

-